Artikkel

KI avslørar ikkje falske videoar

Fem KI-verktøy er testa om dei kan avsløre video laga med Sora. Både folk og digitale verktøy let seg lure. Det kan bli kaos, åtvarar professor.

«Ei alvorleg trafikkulykke har i ettermiddag stengt E39 ved Tengs i Egersund. Ein minibuss og ein personbil kolliderte front mot front. Til saman 15 personar er bekrefta...»

Stemma til det som høyrest ut som ein kvinneleg nyheitsreporter, fortel om den dramatiske ulykka.

Så sluttar den fiktive nyheitsvideoen laga av programmet Sora frå OpenAI.

Få Faktisk.no rett i innboksen. Klikk her for å melde deg på vårt ukentlige nyhetsbrev

Er dette Ai?

SORA2 frå OpenAI og Googles Veo3 er begge videoappar som lager kunstige videoar av høg kvalitet. No er Sora berre tilgjengeleg for dei som har ein kode eller bruker VPN, og det er ukjent når den blir fritt tilgjengeleg for alle.

Ofte er videoane til underhaldning: Jesus vinn eit svømmestemne ved å gå på vatnet, Donald Trump blir pågripen i ballettkostyme og Martin Luther King er standupkomikar.

Appane kan også brukast til å lage falske nyheiter.

– Det gjer jo at veldig mange får mektige verktøy til å forvirre andre.

Det seier Petter Bae Brandtzæg som er professor i kommunikasjon ved Universitetet i Oslo. Han forskar på korleis ulike KI-verktøy påverkar demokratiet.

Unge han intervjuar blir påvirka.

– Nå er det blitt sånn: «Er dette AI? Er dette AI?» Og då bryt samtalen litt saman, fordi ein veit ikkje kva som er ekte, og kva som er KI -generert lenger. Til og med det som er ekte, blir mistenkeleg.

I forskning er dette kjend som «reality apathy» ifølge Brandtzæg. Det er ein slags realitetsapati. Autentiske hendingar blir også møtt med tvil og skaper ein slags apati eller likegyldigheit mot verda.

Falske nyheiter

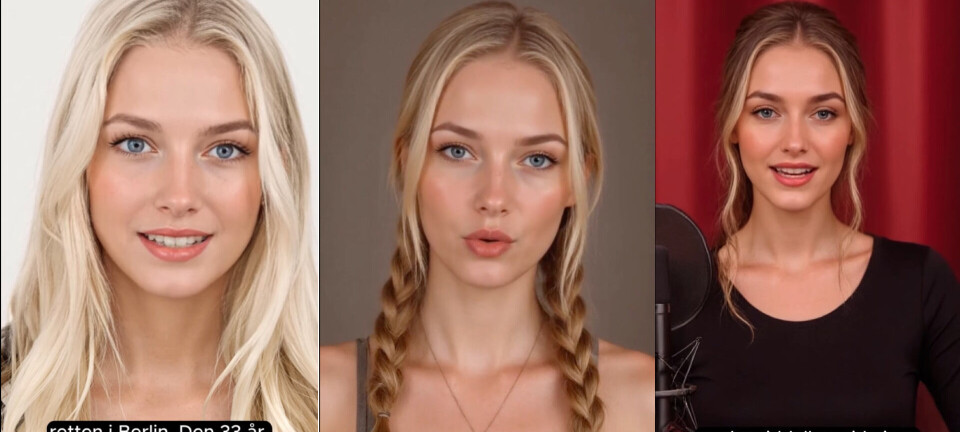

TikTok-kontoen FALSKE Norske Nyheter legg ut Sora-videoar som viser reporterar på jobb. Sjølve namnet gjer det tydeleg at videoane berre etterliknar nyheiter.

Profilen publiserte den første videoen sin i oktober i år, med ein «reell» nyheitsvideo frå Dagbladet.

I ein av videoane fortel ein reporter at regjeringa har bestemt at alle nye bilar må vere elektriske frå 2026.

@norsk.nyheter 2026 Blir det KUN elbiler🚘 #norge #nyheter #2026 #sora #norsk ♬ original sound - FALSKE Norske Nyheter

Dette stemmer ikkje.

Sora-logoen viser at videoen er fiktiv. Likevel oppfattar fleire dette som ein ekte nyheit i kommentarfeltet.

Dei kommenterer at dei er kritiske og sinte fordi regjeringa vil forby nye fossilbilar.

Videoen er både merka med logoen til Sora og hashtagen #sora, for å gjere det klart at den er laga med KI.

Der er andre teikn til at den er falsk, som skrivefeil i videoane. Dei manglar ein open avsendar, og dei er vage om kor i Noreg dette skal vere.

Sora-appen liknar på TikTok i formatet, men alle videoane er generert av brukarane. Dei er altså falske. Videoane kan bli lasta ned og publisert kor som helst. Slik kan falske nyheitsvideoar spreie seg fort.

— Ein kan skape veldig mykje forvirring og tvil, som kan føre til informasjonskaos i samfunnet og økt polarisering. Det kan også bryte ned tilliten mellom mennesker, sier Brandtzæg.

Faktisk.no har kontakta TikTok-kontoen «norsk.nyheter», som står bak videoane, men har ikkje fått svar.

Verifiseringsverktøy trur KI er ekte

Klarer verktøy med kunstig intelligens å avsløre falske videoar? Faktisk.no har undersøkt 15 Sora-videoar henta frå Instagram og TikTok.

Desse er merka med logoen til KI-modellen dei er laga med, for å vise at dei er falske.

Me har køyrd videoane gjennom fire ulike verifiseringsprogram for å teste om KI-verktøy avslører dei.

Slik klarte dei seg:

Ingen av programma klarte å avsløre alle videoane.

Språkmodellen Grok oppdaga KI i Sora-videoane flest gongar. Deepware kom ut dårlegast.

Verktøy til verifisering av KI-genererte videoar har aldri vore feilfrie. Men kvaliteten på Sora har blitt betre – og vanskelegare å oppdage som KI-generert av detektorar.

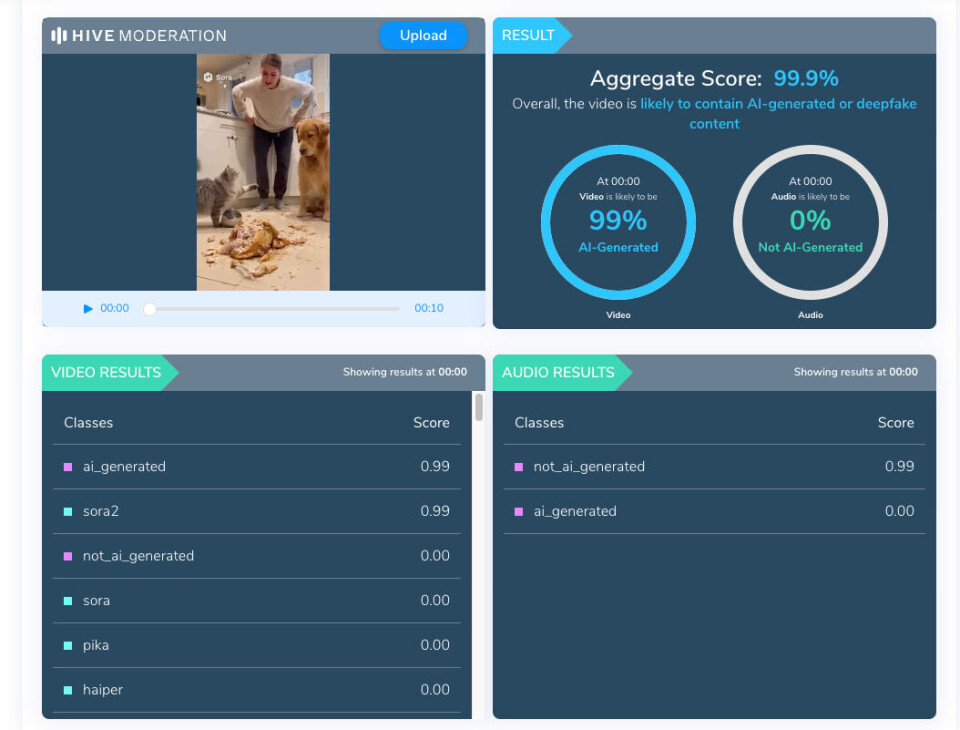

Verktøya som måler den tekniske kvaliteten (her: Deepware, InVid og HiveAI) på videoane var usamde om kva som er KI-genererte videoar. Dei var aldri samkøyrde på nokon av videoane under testen vår.

Store språkmodellar (her: Grok og ChtGPT) fekk færre feil under testen. Grok plukka opp på kontekst og bakgrunnsinformasjon som avviste at videoane kunne vere ekte.

For ordens skuld, då den same spørringa blei gjort med ChatGPT, skilte den seg ut ved å ikkje gi ei vurdering av om videoane er ekte. Den gav i berre tips om korleis ein kan avsløre ein falsk video.

Om me berre går utifrå kvaliteten på videoen, blir det endå vanskelegare for verktøya og våre eigne auge å sjå kva som er ekte, og kva som er KI-generert.

Bruk auga

Ein av videoane me undersøkte med verktøya våre, kjem frå Instagram.

Medan ei dame kjeftar på ein katt, peikar katten febrilsk mot hunden. Det er nesten som om katten skuldar hunden for å stå bak.

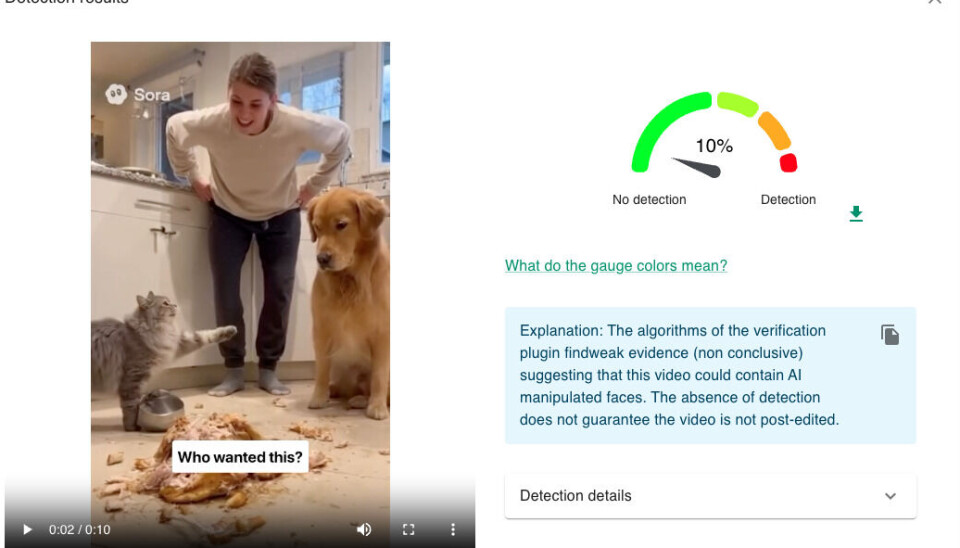

Verktøya var usamde om videoen var falsk eller ekte.

Det eine verktøyet fekk utslag på 99 prosent sannsyn for at videoen er KI-generert. Eit anna meinte at videoen truleg var ekte med berre 10 prosent sannsyn for at den var laga av KI.

Ved første blikk ser videoen reell ut, men noko skil seg ut:

Venstrehanda til dama kviler mot hofta. Tommelen er vendt ned i staden for opp, slik den skal gjere.

Matskåla ved katten rører seg kraftig der katten knapt er borti. Forma på skåla er nærast trekantforma og ser kunstig ut.

Bakbeinet til hunden er synleg, men står i ein unaturleg vinkel under kroppen.

Kyllingbeinet i forgrunnen har underlege skugger under seg.

Nye verktøy

Sjefen for OpanAI, Sam Altman, har sjølv sagt at han er engsteleg for kva appen kan bidra til.

Ekspertar fryktar at appen vil endre oppfatninga av verkelegheita, og at bildebevis kan bli ubrukeleg fordi det blir vanskeleg å skilje ekte frå falske bevis.

Opphavsrett og spreiing av rasistiske framstillingar av jødar, muslimar og andre minoritetar skjer også i appen.

Washington Post skreiv nyleg at teknologien som gjer det mogeleg å flagge kunstig innhald som falsk, ikkje blir nytta når genererte videoar blir lasta opp på plattformer som Facebook og TikTok.

Eigaren av KI-verktøyet Grok, Elon Musk, sa tidlegare i oktober at han vil lansere eit verktøy som kan oppdage om ein video er falsk eller ikkje.

OpenAI har fått kritikk for at appen deira lar folk lage falske videoar av kjente personar, og av materiale beskytta av opphavsrett. Selskapet har forsøkt å hindre dette, men ifølge medieoppslag har dei ikkje lykkast heilt.

Brandtzæg meiner likevel at utviklinga også kan bane veg for noko heilt nytt.

– Når både tenestene til Meta og TikTok omfamna denne KI-genererte verkelegheita, så kan det jo vere at det dukkar opp KI -frie sosiale medium.