Artikkel

Slik brukte vi KI til å forstå TikTok

Faktisk.no har analysert nær 37 000 TikTok-videoer fra norske influensere sammen med AI Journalism Resource Center ved OsloMet. Her beskriver vi hvordan vi har samlet inn dataene i prosjektet og hvordan vi jobber med å analysere videoene.

Denne artikkelen ble publisert for over 1 år siden og kan inneholde utdatert informasjon.

Høsten 2023 bestemte vi oss for å se nærmere på norsk TikTok. Tidligere har blant andre NRK dykket ned i enkelttema på TikTok, som treningsinfluensere, forskjellene mellom russiske og ukrainske feeder og – i samarbeid med Faktisk.no – ungdommer som går viral fra lukket avdeling, der de utleverer sine egne psykiske lidelser.

I dette prosjektet har vi gått bredere til verks. Vårt mål har vært å få en bedre forståelse av den offentlige samtalen på TikTok – en del av offentligheten som har stor innflytelse, spesielt blant unge, men som også har vært et lukket rom for journalistiske undersøkelser. Det skyldes i stor grad at det finnes få offisielle muligheter til å hente ut data fra TikTok.

Inspirert av Svenska Dagbladets prosjekt «AI lyssnar på poddar», som brukte GPT-modeller fra OpenAI til å «høre gjennom» den populære podkasten «Alex och Sigge», bestemte vi oss for å la KI se alle videoene til mange av de mest kjente norske influenserene.

Det ble til sammen nesten 37 000 videoer lagt ut av kjente norske influensere, eller nær 600 timer med norsk TikTok-innhold. Tematikken i videoene varierer fra det hverdagslige til det politiske, fra hvordan man kan få best pump i skuldermusklene til hvordan ytringsfriheten er under press.

Profilene vi så på ble valgt ut gjennom en kombinasjon av kunnskap om hvilke kontoer som engasjerer seg mest i «debatten» på TikTok og undersøkelser av hvilke TikTok-skapere som er mest populære. Datamaterialet gir dermed informasjon om et utsnitt av det samlede norske TikTok-universet, ikke et totalbilde.

NB: Prosjektet er pågående. Denne artikkelen vil bli oppdatert fortløpende etter hvert som vi publiserer artikler med nye funn og analyser.

Datainnsamling

De 37 000 videoene vi har gått gjennom i dette prosjektet har blitt samlet inn gjennom en kombinasjon av webscraping – å hente ut innhold fra nettsider – og bruk av et betalt API.

Vi har først hentet ut lenker til hver av videoene fra profilene influenserne vi har villet undersøke nærmere ved hjelp av webscraping. Deretter har vi sendt disse lenkene til en API-tjeneste som lar oss hente ut videoen hver lenke peker til, samt metadata om videoen – blant annet antall visninger, kommentarer og likerklikk den har fått, og opptil 50 av kommentarene videoen har fått.

Databehandling og analyse

Vi har analysert videoene vi samlet inn ved hjelp av ulike KI-modeller og maskinlæringsteknikker. I tillegg har vi brukt tradisjonell dataanalyse og språkteknologi. Under beskriver vi hvordan vi har behandlet og analysert datamaterialet vårt.

Transkribering: Alle videoene har blitt automatisk transkribert ved hjelp av OpenAIs Whisper-modell. For å sikre at viktige ord og begreper staves så likt og korrekt som mulig, slik at de kan brukes i senere analysetrinn, har vi brukt modellen Whisper-large. Etter testing ga den betydelig bedre resultater enn mindre modeller. Vi gjennomførte vår analyse før Nasjonalbiblioteket publiserte sin egen Whisper-modell.

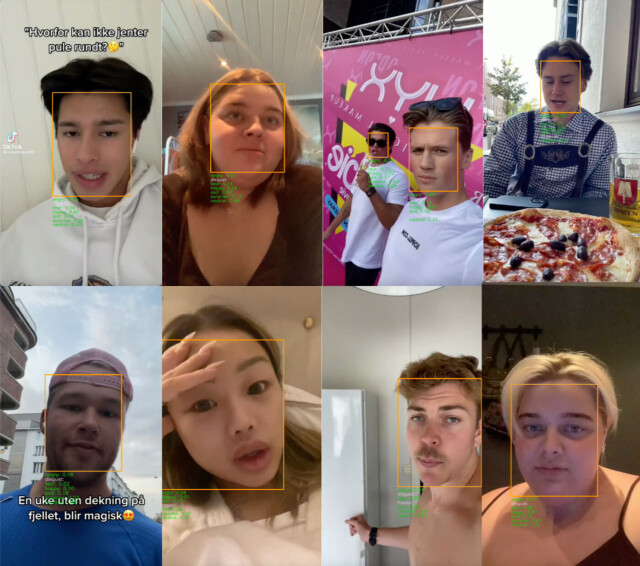

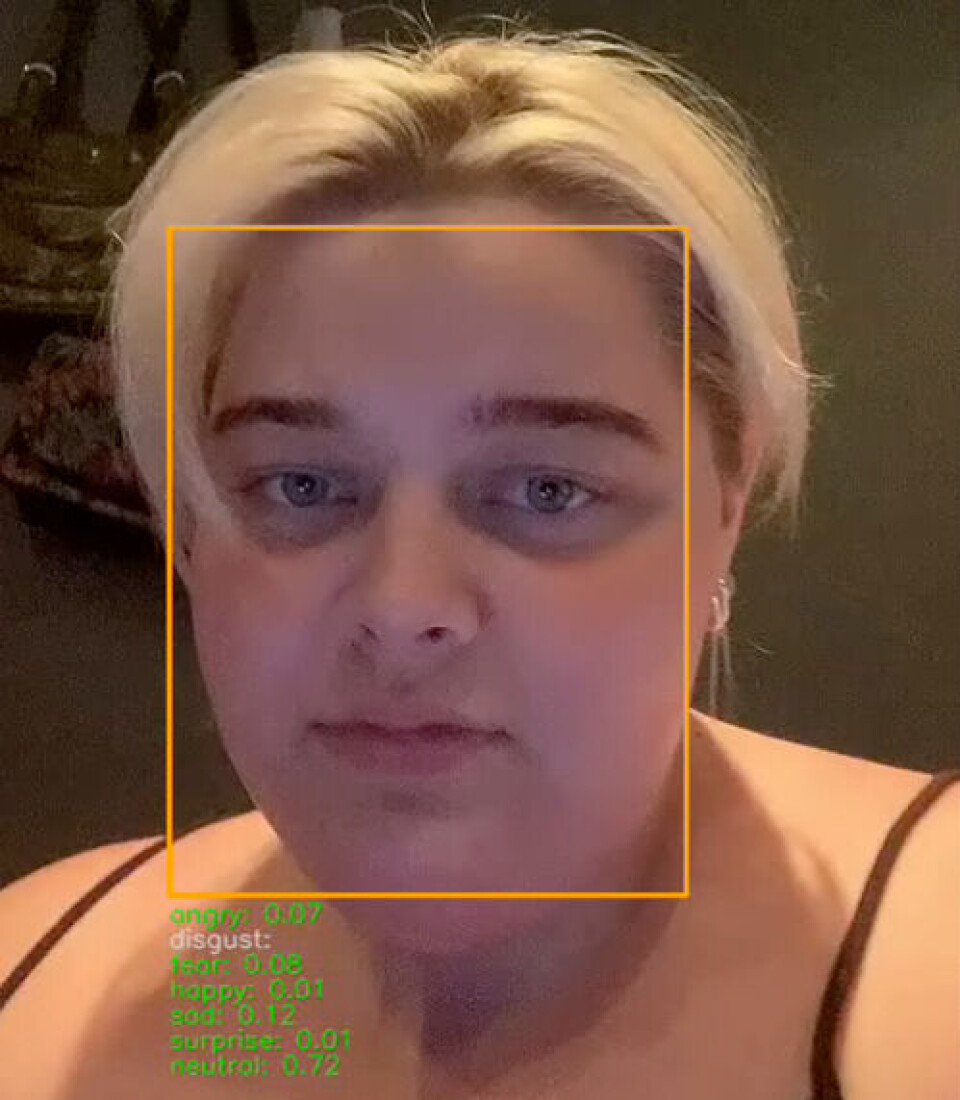

Sentimentanalyse: Vi har forsøkt å identifisere hva slags stemning eller følelse hver enkelt video uttrykker. I denne analysen har vi basert oss på tre kilder til informasjon i videoene: ansiktsuttrykket til personene som opptrer i videoen, hva de sier, og videotittelen.

For å analysere ansiktsuttrykk har vi brukt modellen Facial Expression Recognition (FER), mens vi har brukt den BERT-baserte modellen scandi-nli-large til å analysere hva som blir sagt i videoen. Denne modellen er finjustert av det danske Alexandra-instituttet, og bygger på en av det norske Nasjonalbibliotekets språkmodeller.

Ingen av de tre informasjonskildene vår analyse bygger på gir fullstendig informasjon om følelsene som kommer til uttrykk i en gitt video. Klassifiseringen vår er derfor basert på et vektet gjennomsnitt av alle tre. I klassifiseringen tillegges ansiktsuttrykk og det som blir sagt i videoen mer vekt enn videotittelen (fordelingen er 40%-40%-20%).

Selv om dette fremdeles innebærer noe usikkerhet, har gjentatt testing vist at de aller fleste videoer blir kategorisert på en tilstrekkelig pålitelig måte til at vi kan si noe om hvordan stemningen i det hjørnet av TikTok vi har undersøkt har utviklet seg og hva slags stemning som er mest fremtredende på en gitt konto.

I utgangspunktet identifiserer vi seks ulike følelser eller stemninger: glede, overraskelse, sinne, frykt, redsel og «nøytral». Når vi skal se på utviklingen i hele datamaterialet over tid, har vi derimot benyttet oss av en enklere positiv/negativ-kategorisering, der sinne og avsky er negative følelser, mens glede og overraskelse er positive følelser. Dette lar oss være sikre på at trendene vi identifiserer, er reelle, men gjør det også mulig for oss å gi mer detaljerte beskrivelser der vi mener at det er grunnlag for det.

I tillegg har vi kunnet knytte stemningen vi har sett til andre deler av datamaterialet, slik at vi for eksempel kan undersøke om negative videoer får flere visninger enn positive videoer.

Kjønnsforskjeller

Vi har også sett på kjønnsforskjeller mellom influenserene i datamaterialet vårt. For å gjøre det, har vi først kodet alle influensere som enten menn eller kvinner, og deretter analysert stemningene i videoene til hvert kjønn.

Én ikke-binær influenser som ble utelukket fra analysen, siden en enkeltperson ikke er nok til å gjennomføre en gruppeanalyse.

Underveis arbeidet fikk vi en mistanke om at KI-modellen vi brukte til ansiktsgjenkjenning tolket menns og kvinners ansiktsuttrykk ulikt, og spesielt om den var mer tilbøyelig til å oppfatte manneansikter som sinte.

Vi undersøkte derfor hvilken effekt det hadde på kategoriseringen av videoene om vi fjernet ansiktsanalysen fra regnestykket. Vi var spesielt opptatt av om videoer laget av menn ble tolket som mindre sinte og av om effekten var ulik for kvinner og menn.

Denne analysen viste at selv om det å fjerne ansiktsanalysen hadde en effekt, var kjønnsforskjellene små. Vi er derfor trygge på at i KI-modellen vi har brukt ikke systematisk tolker menns ansiktsuttrykk annerledes enn kvinners.